الذكاء الاصطناعي: تكنولوجيا عملاقة ستعالج مشاكل هائلة وأزمات طويلة.. ولكن ليس من بينها التمييز ضد النساء

في إطار عمله على تحقيقٍ لصالح وكالة بلومبرغ الإخبارية (Bloomberg)، استخدم ليوناردو نيكوليتي الصحافي المتخصص في التصوير البياني (Data Visualization) نموذج الذكاء الاصطناعي (Stable Diffusion) الذي ينتج صورًا واقعية بناءً على وصف يكتبه المستخدمات والمستخدمون. وفي أثناء اختباره للنموذج الذي استمر لشهور، طلب نيكوليتي ذات مرة صورًا لـ«قضـاة»، فإذا بـ 97 في المئة من النتيجة هي صور لرجال في مقابل 3 في المئة فقط لنساء يعملن بالقضاء. لفتت النتيجة نظر نيكوليتي وراودته شكوك بشأن وجود مشكلة في تصميم خوارزميات النموذج أدت إلى ظهور النتيجة على هذا النحو المتحيز لجنس على حساب الآخر، إلا أن هذه الشكوك تأكدت لاحقًا بعد أن أظهر النموذج نتائج مماثلة في استجاباته التالية لطلبات نيكوليتي لصور عن فئات مختلفة، إذ بدا التحيز على أساس الجنس نسقًا في جل النتائج.

هذه الواقعة استشهد بها الصحافي الإيطالي ليوناردو نيكوليتي، في خلال مشاركته بقمة (HeForShe) التي عقدتها منظمة الأمم المتحدة للمرأة في سبتمبر من العام 2023، وقد فعل ذلك للتدليل على أن تكنولوجيا الذكاء الاصطناعي ستؤدي إلى مفاقمة الصور النمطية المرتبطة بالنساء وستعمّق التباينات الموجودة بين الجنسين، مؤكدًا أن الأمر لن يقتصر على استنساخ القوالب النمطية بل سيجعلها تبدو أسوأ كثيرًا مما هي عليه في الواقع.

تحيز برمجيات الذكاء الاصطناعي لاحظته كذلك الباحثة وعالمة الحواسيب الأمريكية جوي بولامويني، وبالأخص في أدوات تحديد الوجوه التي باتت تعتمد عليها العديد من الشركات الرائدة في مجال الذكاء الاصطناعي، وقد رصدت الباحثة المشكلة عندما تبين لها عدم قدرة هذه الأدوات على تحليل صورتها كمتحدثة في خلال أحد مؤتمرات تيد (TED)، إذ لم تتمكن بعضها من التعرف إلى وجهها بينما صنفه بعضها الآخر وجهًا لرجل نتيجة عدم تطابق مقاييسه مع ما تحدده الخوارزميات للوجه الأنثوي، لتدرك جوي بولامويني حينها أن ثمة مشكلة مشتركة في نماذج الذكاء الاصطناعي تلك، وهي إنشاؤها استنادًا إلى مدخلات بيانية متحيزة على أساسي نوع الجنس ولون البشرة، ولهذا لم تتمكن أي من الأدوات التي اختبرتها من تحليل وجهها أو تصنيفه وجهًا لامرأة، لأنها من ذوات البشرة السوداء، صاحبات الشعر المجعد، وقد اختارت أن يكون شعرها قصيرًا للغاية بقصة الشعر التي عرفت منذ بدايات القرن الماضي باسم (mode à la garçonne) أي قصة شعر الرجل.

حفزت هذه الحادثة جوي على إطلاق مشروع تجريبي للبحث في مسألة تحيزات الذكاء الاصطناعي خاصةً على أساس النوع الاجتماعي، وقد تعاونت في العام 2017 مع مجموعة من الباحثات والباحثين في معهد ماساتشوستس للتكنولوجيا (MIT) لتنفيذه تحت عنوان ظلال الجندر (Gender Shades). وقد عكف الفريق على مدى ثلاث سنوات على تحليل 1270 صورة لنساء باستخدام مجموعة من نماذج تحليل الوجوه التابعة للشركات الرائدة في تكنولوجيا الذكاء الاصطناعي مثل مايكروسوفت (Microsoft) وآي بي أم (IBM)، وقد انتهى البحث إلى وجود تحيز حاد على أساسي النوع واللون في عمليات التصنيف التي تجريها أشهر نماذج الذكاء الاصطناعي المعدة لهذه المهمة.

ويسجل الباحثات والباحثون عبر الموقع الخاص بمشروع ظلال الجندر (Gender Shades) النتيجة الأهم لبحثهم، وهي أن «النظم الآلية تفتقر إلى الحيادية بل تعكس الأولويات والتفضيلات والتحيزات لهؤلاء الذين لديهم القدرة على تشكيل وتصميم الذكاء الاصطناعي، وهو ما يسمّى بالنظرة المكوّدة (The Coded Gaze).»

وقد اكتشف باحثات وباحثون في جامعتي واشنطن وميونيخ التقنية أن النظرة المكوّدة التي تصنّف المهن، والمشاعر، والصفات، والأشياء، وفقًا لأكواد جندرية ثنائية تقسمها بين ذكوري وأنثوي، تهيمن بوضوح على نموذج خوارزميات اسمه (CLIP) أطلقته منظمة الأبحاث في مجال الذكاء الاصطناعي (Open AI) في العام 2021، لتحويل التعليق النصي إلى تصنيفات بصرية عن طريق استخراج صور من الإنترنت تتوافق معه. وقد تيقنوا من ذلك عقب تدريبهم لروبوتات افتراضية (Virtual Robots) لكي تعمل تبعًا لخوارزميات نموذج (CLIP)، ثم طلبوا منها تصنيف «أرباب/ربات البيوت – Homemakers» بصريًا، فكانت الاستجابة بصور معظمها لنساء من ذوات البشرة السوداء واللاتينيات، بينما جاء القليل منها لرجال من ذوي البشرة البيضاء، ولم تبتعد كثيرًا الاستجابة التي جاءت لطلبهم تصنيفات بصرية لـ«الطبيبــ/ة – Doctor»، فقد استحوذت صور الأطباء الرجال على النسبة الأكبر من النتيجة.

كيف تتحيز أنظمة الذكاء الاصطناعي ضد النساء؟

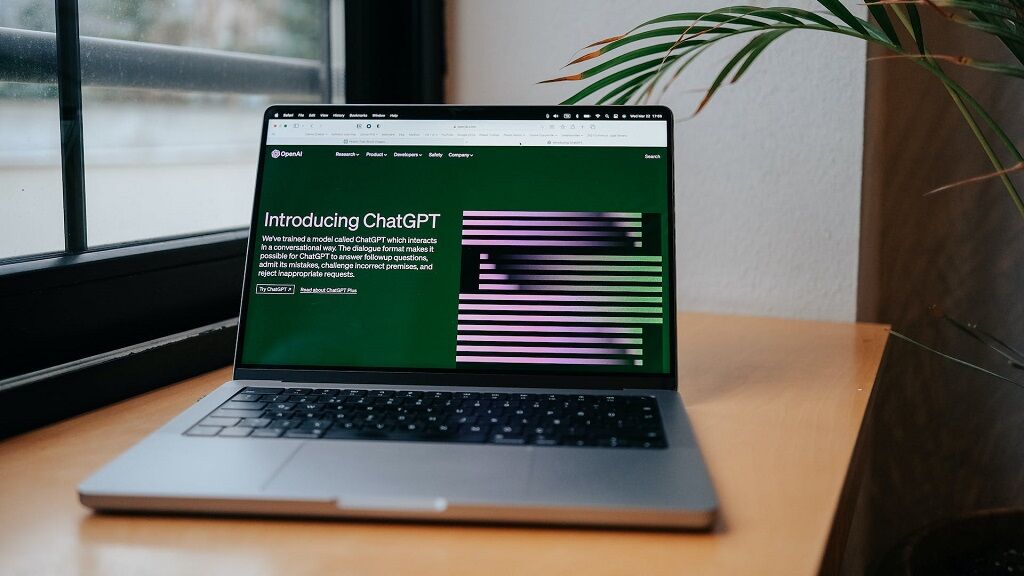

الذكاء الاصطناعي هو مجال فرعي في علوم الحواسيب، وقد ظهرت بوادره في خمسينيات القرن الماضي، إلا أن الطفرة الكبيرة التي نشهدها حاليًا بدأت بعد العام 2010، على أيدي شركات كبرى في مجال التكنولوجيا، أبرزها: جوجل (Google)، ومايكروسوفت (Microsoft)، وأمازون (Amazon Web Services).

الشكل الأكثر شيوعًا في الوقت الراهن لهذه التكنولوجيا هو الذكاء الاصطناعي التوليدي (Generative AI) الذي ينتج صورًا ونصوصًا ومقاطع مصورة، أو يجيب عن أسئلة ويشخّص أمراضًا كما لو كان البشر هم من يفعلون ذلك.

يرتكز الذكاء الاصطناعي التوليدي إلى كم هائل من البيانات المجمعة التي ينتجها الأفراد كالمحتوى الإبداعي والأكاديمي والبحثي المتاح عبر الإنترنت أو تنتجها أدوات من صنع الأفراد مثل برامج الرصد والمراقبة وأجهزة الاستشعار عن بعد، إذ تعمل البرمجيات على دراسة هذه البيانات لإنشاء أنظمة ذاتية التعلم تستخلص المفاهيم والمعاني منها، ثم تطبق المعرفة المخلّقة على نحو يناظر التطبيق البشري.

كل هذه العملية يقف وراءها البشر، ومن ثم فما من غرابة في أن ينتقل التحيز الجندري من الأفراد إلى هذه التكنولوجيا خاصةً أثناء مرحلتي جمع البيانات وتصميم الخوارزميات وتنفيذها، سواء كانت نماذج الذكاء الاصطناعي معدة لتحديد الوجوه، أو إنشاء الصور الواقعية، أو إنتاج محتوى إبداعي كمقاطع الفيديو والمقاطع الصوتية، أو كتابة النصوص وتحريرها، أو تحويل النصوص إلى رسوم، أو إتمام بعض مهام البرمجة. وهذا ما أكدت عليه الباحثات سوبادرا بانشاناديسواران، وأردرا ماناسي، وسيونج جو لي، وإميلي سورس في دراستهن «استنساخ التحيز: النوع الاجتماعي والذكاء الاصطناعي» المنشورة في الدورية الأكاديمية (Gender, Technology and Development)، والتي يجادلن فيها بأن التحيزات الجندرية تجد مسلكها إلى أنظمة الذكاء الاصطناعي في أثناء تصميم المطورين والتقنيين للتعليمات المتسلسلة اللازمة للإجابة على الأسئلة والطلبات التي تُوجّه إليها والمعروفة باسم «الخوارزميات»، وقد تنتقل التحيزات من الأفراد إلى الآلة في مرحلة معالجة البيانات المجمعة أو تدريب نماذج الذكاء الاصطناعي على التنبؤ واتخاذ القرار استجابة للمستخدمات والمستخدمين.

وفقًا للدراسة المنشورة في نوفمبر من العام 2022، فإن البيانات المستخدمة في نماذج الذكاء الاصطناعي غالبًا ما تفتقر إلى التنوع وتتمحور حول الذكر، مما يؤدي بالتبعية إلى ظهور نتائج منحازة إلى الرجال لا سيما ذوي البشرة البيضاء، أو نتائج خاطئة تمامًا مثلما حدث مع الباحثة وعالمة الحواسيب جوي بولامويني كما أشرنا آنفًا.

بالإضافة إلى ذلك، تذكرُ الباحثات الأربع أن التحيز الجندري يظهر بوضوح في روبوتات المساعدين الافتراضيين/المساعدات الافتراضيات (Virtual assistants)، التي تستطيع تنفيذ العديد من المهام الروتينية اليومية بناءً على الأوامر التي تتلقاها من المستخدمات والمستخدمين، مثل القراءة الصوتية للرسائل النصية أو رسائل البريد الإلكتروني، والبحث عن أرقام الهواتف، وجدولة اللقاءات الافتراضية والواقعية، وإجراء المكالمات الهاتفية، والتذكير بالمواعيد، والتنبيه إلى أحوال الطقس. وتتوقف الباحثات أمام اختيار الشركات الأكبر في هذا المجال أن تكون أصوات هذه الروبوتات أصواتًا نسائية، وهو الأمر الذي يعتبرنه إدامة للتقسيم النمطي للأعمال والمهن على أساس نوع الجنس، فلطالما كانت النظرة الاجتماعية إلى الأعمال الإدارية ومهام السكرتارية بوصفها اختصاصات نسائية.

وفي هذا السياق، تتوقف الباحثات أمام اسم سيري (Siri) الذي اختارته شركة آبل (Apple) للمساعد/ة الذكـيـ/ة الخاصـ/ة بها، وهو اسم نسائي اسكندنافي تعود جذوره إلى اللغة النوردية القديمة ويعني المرأة الجميلة التي تقود الآخرين/الأخريات إلى النصر، وكذلك اسم أليكسا (Alexa) الذي أطلقته شركة أمازون على نموذجها للمساعدين الافتراضيين، وهو اختصار للاسم النسائي أليكساندرا الذي يعني المدافعة عن الرجل. وتكشف الباحثات في دراستهن أن هذا النوع من التحيز على أساس الجنس يأتي مردوفًا بتوقعات وقوالب نمطية، ويساهم في استمرار التمييز ضد النساء في المجتمع.

ماذا بعد رصد المشكلة والتحقق من شيوعها؟

تعزي غابرييلا راموس، المديرة العامة المساعدة للعلوم الاجتماعية والإنسانية في اليونسكو (UNESCO)، التحيز الجندري في مجال الذكاء الاصطناعي إلى تهميش النساء في كل خطوة في دورة حياة هذه التكنولوجيا الحديثة التي تقود عملية التحول الرقمي الجارية، إذ تكشف بيانات المنتدى الاقتصادي العالمي الصادرة في العام 2023 أن النساء يمثلن 30 في المئة من المتخصصين في مجال الذكاء الاصطناعي على المستوى العالمي، أما الباحثات في هذا المجال فتبلغ نسبتهن نحو 14 في المئة وفقًا لمنظمة اليونسكو.

ويحذر التقرير السنوي للمنتدى الاقتصادي العالمي في نسخته الأخيرة من استبعاد وجهات نظر النساء وتجاربهن ورؤاهن في تطوير نماذج الذكاء الاصطناعي وتفعيلها، لما لذلك من تبعات تتعلق باستمرار الاعتماد على خوارزميات وتقنيات متحيزة جندريًا، مما يهدد بحلول واستجابات متحيزة في تحديات ناشئة ومجالات كثيرة صار الاعتماد على الذكاء الاصطناعي فيها حاسمًا مثل: الأعمال المعرفية (تكنولوجيا المعلومات والاتصالات، والطب، والصيدلة، والهندسة، والعلوم، والكتابة والتحرير، والبحث الأكاديمي،..)، والتعليم، والصحة، والبيئة، والتوظيف.

وتعتبر غابرييلا راموس العضوة بمنظمة اليونسكو أن أحد أهم السبل لمعالجة المشكلة هو استحداث أداة معيارية عالمية لتوجيه عمليات تطوير واستخدام الذكاء الاصطناعي بما يضمن صلاحيته للجميع خاصةً النساء والفتيات، مشيرةً إلى أن اليونسكو أخذت خطوة في هذا الاتجاه عندما أعلنت عن توصية بشأن «أخلاقيات الذكاء الاصطناعي»، لدفع الحكومات إلى اتخاذ إجراءات فعالة وملموسة لتحقيق قيمة التنوع والشمول، ومبدأ العدالة وعدم التمييز في الفضاء الرقمي. وقد طالبت التوصية الدول بالاستثمار في البرامج التي تهدف إلى زيادة فرص مشاركة الفتيات والنساء في تخصصات العلوم، والهندسة، والرياضيات، وتكنولوجيا المعلومات والاتصالات، ومعالجة إشكالية الفجوة في الأجور بين الجنسين وتكافؤ الفرص في العمل بالأخص في مجالات العلوم والتكنولوجيا.

أما الباحثة والأكاديمية سوبادرا بانشاناديسواران فتشجع على استخدام أدوات فك التكويد الجندري (Gender Decoders) المطورة أيضًا عبر الذكاء الاصطناعي، لإزالة الكلمات والعبارات التمييزية واقتراح بدائل أكثر شمولًا وحيادية، والتي تنامى الاعتماد عليها في السنوات الأخيرة لمراجعة وتحليل إعلانات الوظائف.

وتحدد أداة فك الأكواد المجندرة، بعد مراجعة النص، الصياغات التي تعكس صورًا وقوالب نمطية أو تكرس لتوقعات اجتماعية إزاء نوع الجنس، ثم تطرح على المستخدمات والمستخدمين كلمات وجمل أخرى لتحسين لغة الإعلان على صعيدي الحساسية والشمول الجندريين، حتى يشعر الجمهور المستهدف بأن الوظيفة متاحة أمام الجميع وليس فئة أو مجموعة بعينها، وأن الفرص متساوية بين الكل بغض النظر عن اختلاف الجنس، واللون، والعرق، والحالة الاجتماعية.

علاوة على ذلك، فقد شقت أدوات فك التكويد الجندري طريقها إلى الصحافة والإعلام، حيث بدأت مؤسسات وشركات في هذا المجال العمل على تطوير أدواتها الخاصة لمراجعة المحتوى الذي ينتجه الصحافيات والصحافيون قبل نشره، سواء كان مقروءًا أو مسموعًا أو مرئيًا، لالتقاط ما به من أوصاف وعبارات وكلمات تحمل تحيزًا أو تعكس تصورات نمطية وتعديلها، وينبئ ذلك بميزة مضاعفة ستحققها أدوات فك الأكواد الجندرية لأن الجدوى لن تقف عند إنتاج محتوى إخباري وتوثيقي وتحليلي يتسم بالحيادية ويضمن الشمول، بل ستمتد إلى المساهمة في خلخلة حالة التطبيع تجاه المضامين المتحيزة جندريًا التي تسيطر على كثير من الصحافيين والصحافيات.

by

by